本文对最大期望算法的理解

来自—引入最大期望算法—最大期望算法

来自—最大期望算法实例—EM算法

对照理解李航《统计机器学习》P158 的 Q 函数

定义9.1 (Q函数)

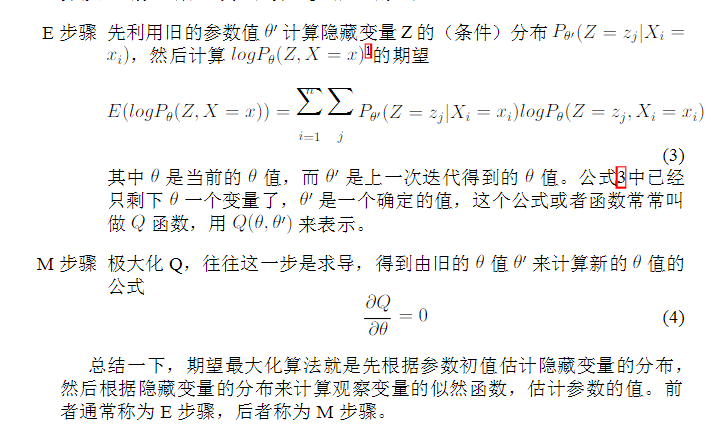

完全数据的对数似然函数 $logP(Y,Z|\theta)$ 关于在给定观测数据 $Y$ 和当前参数 $\theta^{(i)}$ 下对未观测数据 $Z$ 的条件概率分布 $P(Z|Y,\theta^{(i)})$ 的期望成为 $Q$ 函数,即,

完全数据的对数似然函数 $logP(Y,Z|\theta)$ —-> $logPr(X=x,Y=y;\theta’)$

定观测数据 $Y$ —-> $x$

当前参数 $\theta^{(i)}$ —-> $\theta^{(i)}$

未观测数据 $Z$ —-> $y$

条件概率分布 $P(Z|Y,\theta^{(i)})$ —-> $Pr(Y=y|X=x)$

的期望成为 $Q$ 函数 —-> “上面的每行第3列和第4列相乘,最后再按行相加,就得到关于θ(i+1)的函数”

简易速推 Q 公式

在不包含隐变量的情况下,我们求最大似然的时候只需要进行求导使导函数等于0,求出参数即可。但是包含隐变量,直接求导就变得异常复杂,此时需要EM算法,首先求出隐变量的期望值(E步),然后,把隐变量当中常数,按照不包含隐变量的求解最大似然的方法解出参数(M步),反复迭代,最终收敛到局部最优。下面给出EM算法的推导。

我们有对数似然函数:

可以表示成包含隐变量z的形式,然后通过边缘化再消除z,效果是一样的。

由于是迭代,我们需要每次得到的新的似然结果比上一次的似然结果要大,于是我们的目标是下式:

由于L(θ′) 是常量,所以,使得L(θ)最大化即可。下面看看如何最大化 L(θ) :

至此,得到传说中的Q函数,然后求解出参数θ即可。

引入最大期望算法

| 标题 | 说明 | 时间 |

|---|---|---|

| 怎么通俗易懂地解释EM算法并且举个例子? | 知乎 | |

| 机器学习笔记(十)EM算法及实践(以混合高斯模型(GMM)为例来次完整的EM) | 简单引入EM算法 | 20170324 |

| 最大期望算法 | 20121203 |

最大期望算法的应用

最大期望算法实例

| 标题 | 说明 | 时间 |

|---|---|---|

| EM算法 | 本文试图用最简单的例子、最浅显的方式说明EM(Expectation Maximization)算法的应用场景和使用方法,而略去公式的推导和收敛性的证明。 | |

| What is the expectation maximization algorithm? | 解释EM的论文 | 20080101 |

| EM算法(Expectation - Maximization)通俗实例(What is the expectation maximization algorithm?) | What is the expectation maximization algorithm?的翻译 | 20170920 |

最大期望算法的理论推导

| 标题 | 说明 | 时间 |

|---|---|---|

| stanford cs229 The EM algorithm | Andrew Ng 理论推导 | |

| (EM算法)The EM Algorithm | stanford cs229 The EM algorithm 的中文翻译 | 20110406 |

最大期望算法的相关博客

| 标题 | 说明 | 时间 |

|---|---|---|

| EM-最大期望算法 | stanford cs229 The EM algorithm 的中文翻译 + 个人理解 | 20151202 |