CoNLL 2003 是最经典的命名实体识别(NER,Named Entity Recognition)任务数据集之一,有大量的研究者在上面进行研究。如果你对该领域(自然语言处理)有兴趣,不妨以此为任务入手。

BERT Pre-training of Deep Bidirectional Transformers for Language Understanding 翻译

本文是BERT论文的全文翻译,转载注明出处和译者。

- 原文 BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding,这是BERT在2018年11月发布的版本,与2019年5月版本v2有稍许不同。

- PDF版翻译以及相关资源链接 GitHub BERT_Paper_Chinese_Translation

- 译者:袁宵

- 说明:1. 对于没有标准译法的词语保留了原单词;2. 以准确翻译为第一目标,力求保持原意;3. 欢迎读者参与到翻译中来,提出修改意见。

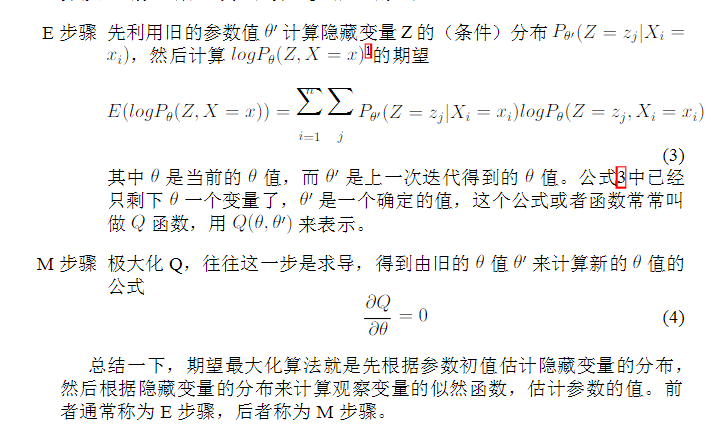

EM最大期望算法

TensorFlow_rnn_cell_impl源码阅读

实现RNN单元的模块。该模块提供了一些基本常用的RNN单元,如LSTM(长短期记忆)或GRU(门控循环单元),以及一些允许为输入添加 dropout、投影连接或嵌入的操作。构建多层单元格由“MultiRNNCellL”类支持,或多次调用 RNN OPS。

Universal Language Model Fine-tuning for Text Classification

摘要:迁移学习为计算机视觉带来了巨大改变,但是现有的NLP技术仍需要针对具体任务改进模型,并且从零开始训练。我们提出了一种有效的迁移学习方法,可以应用到NLP领域的任何一种任务上,同时提出的技术对调整语言模型来说非常关键。我们的方法在六种文本分类任务上比现有的技术都要优秀,除此之外,这种方法仅用100个带有标签的样本进行训练,最终的性能就达到了从零开始、拥有上万个训练数据的模型性能。

SQuAD(Stanford Question Answering Dataset)

TensorFlow_seq2seq_attention_wrapper源码阅读

attention_wrapper

tensorflow/tensorflow/contrib/seq2seq/python/ops/attention_wrapper.py

https://github.com/tensorflow/tensorflow/blob/master/tensorflow/contrib/seq2seq/python/ops/attention_wrapper.py

Bag of Tricks for Image Classification with Convolutional Neural Networks

技巧只能源码找?李沐带你纵览卷积网络实战中的惊艳技艺 https://www.jiqizhixin.com/articles/120805

在这篇论文中,李沐等研究者研究了一系列训练过程和模型架构的改进方法。这些方法都能提升模型的准确率,且几乎不增加任何计算复杂度。它们大多数都是次要的「技巧」,例如修正卷积步幅大小或调整学习率策略等。总的来说,采用这些技巧会产生很大的不同。因此研究者希望在多个神经网络架构和数据集上评估它们,并研究它们对最终模型准确率的影响。

卷积神经网络 Convolutional Neural Networks

Convolutional Neural Networks

CIFAR-10 CNN

In this example, we will download the CIFAR-10 images and build a CNN model with dropout and regularization.