极限

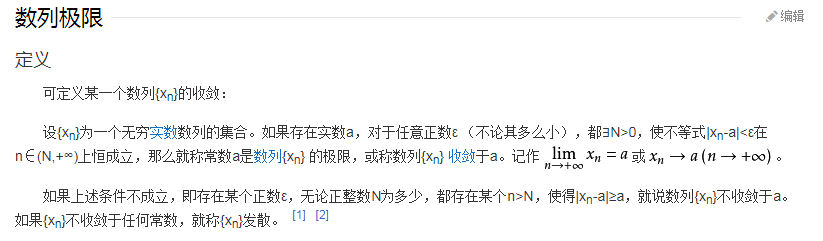

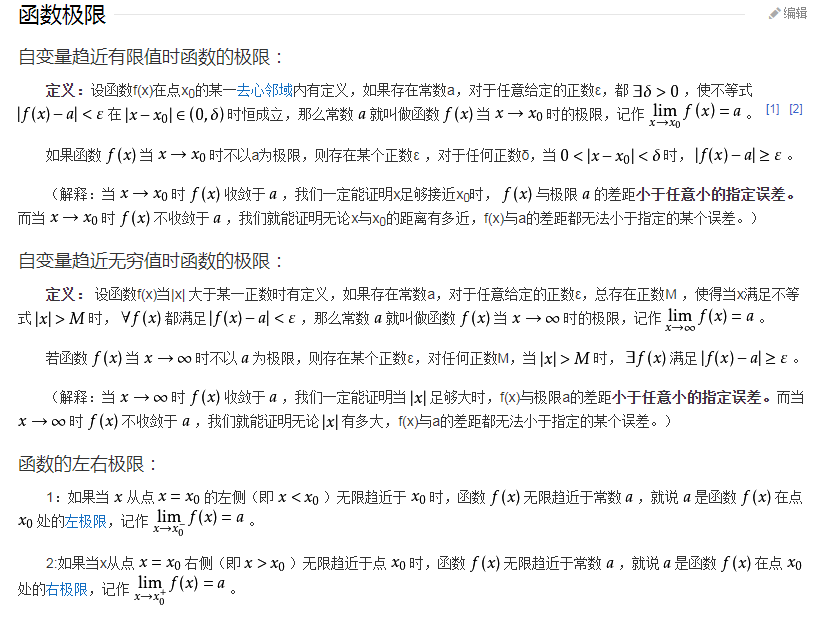

“极限”是数学中的分支——微积分的基础概念,广义的“极限”是指“无限靠近而永远不能到达”的意思。数学中的“极限”指:某一个函数中的某一个变量,此变量在变大(或者变小)的永远变化的过程中,逐渐向某一个确定的数值A不断地逼近而“永远不能够重合到A”(“永远不能够等于A,但是取等于A‘已经足够取得高精度计算结果)的过程中,此变量的变化,被人为规定为“永远靠近而不停止”、其有一个“不断地极为靠近A点的趋势”。极限是一种“变化状态”的描述。此变量永远趋近的值A叫做“极限值”(当然也可以用其他符号表示)。

以上是属于“极限”内涵通俗的描述,“极限”的严格概念最终由柯西和魏尔斯特拉斯等人严格阐述。

极限思想

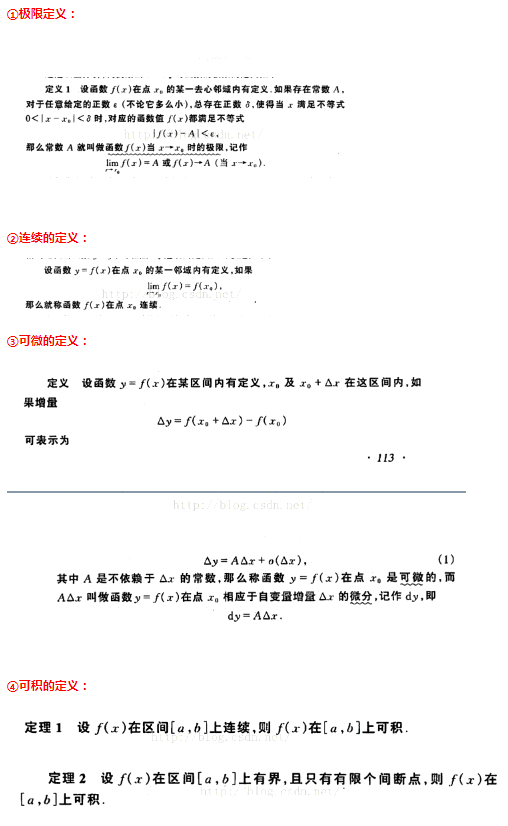

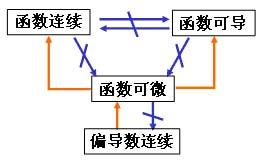

极限、连续、可微、可到、可积之间的关系

对于一元函数有,可微<=>可导=>连续=>可积

对于多元函数,不存在可导的概念,只有偏导数存在。函数在某处可微等价于在该处沿所有方向的方向导数存在,仅仅保证偏导数存在不一定可微,因此有:可微=>偏导数存在=>连续=>可积。

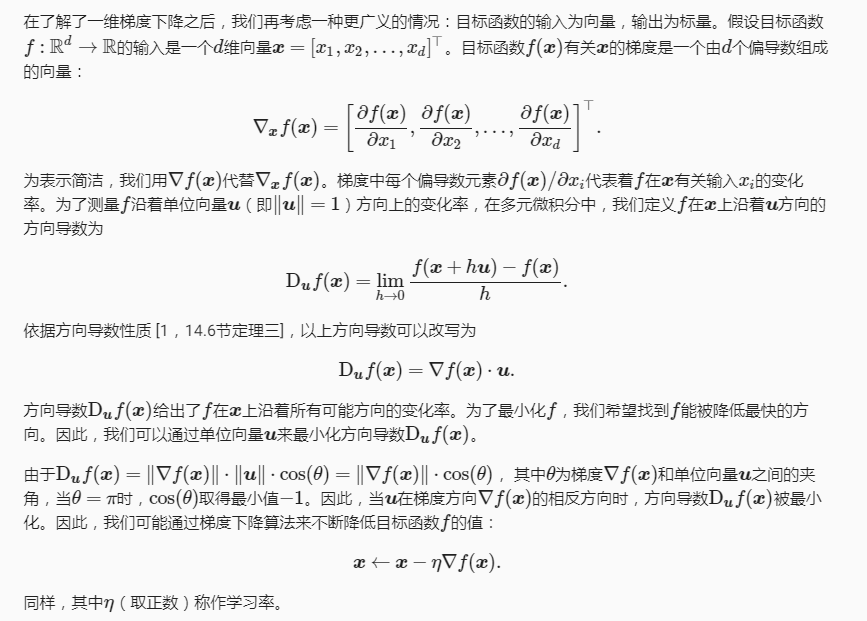

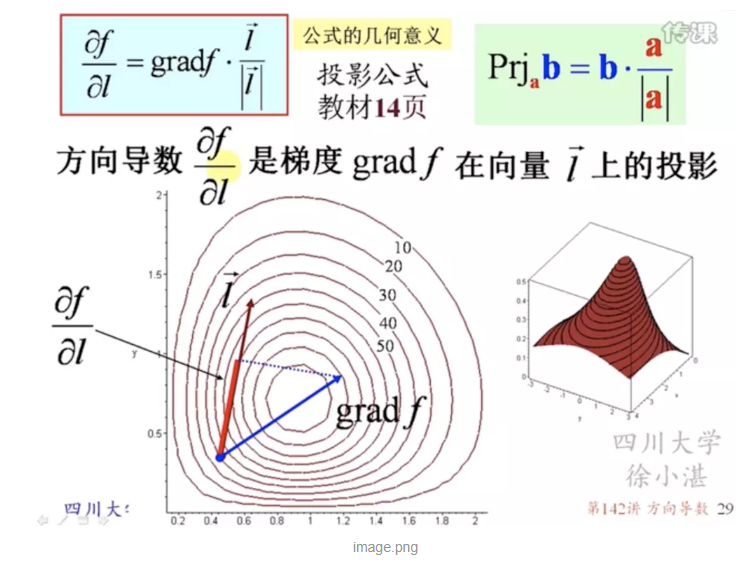

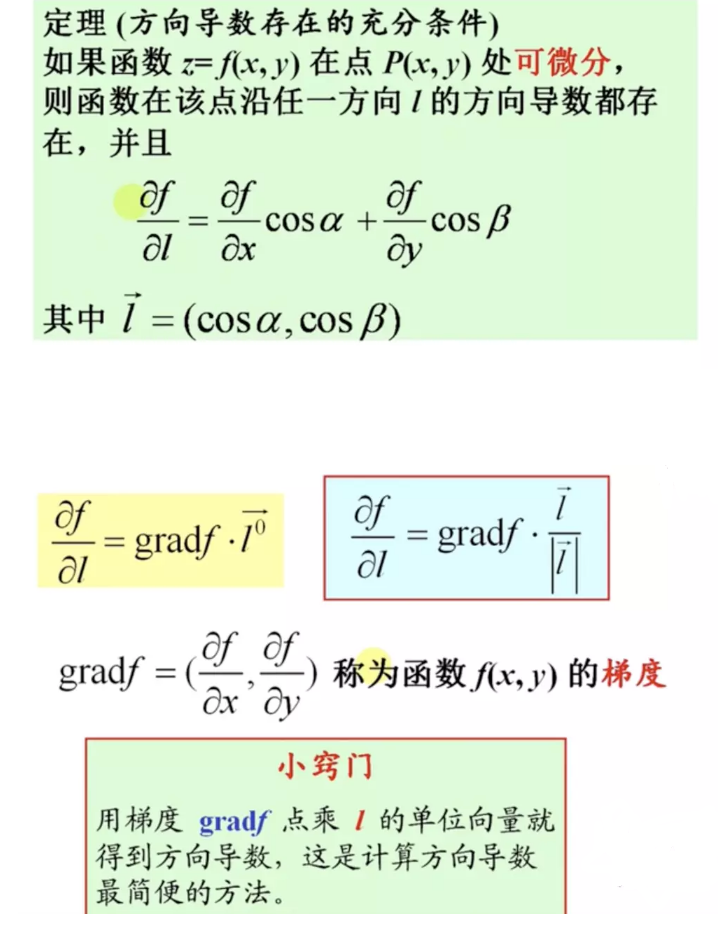

方向导数

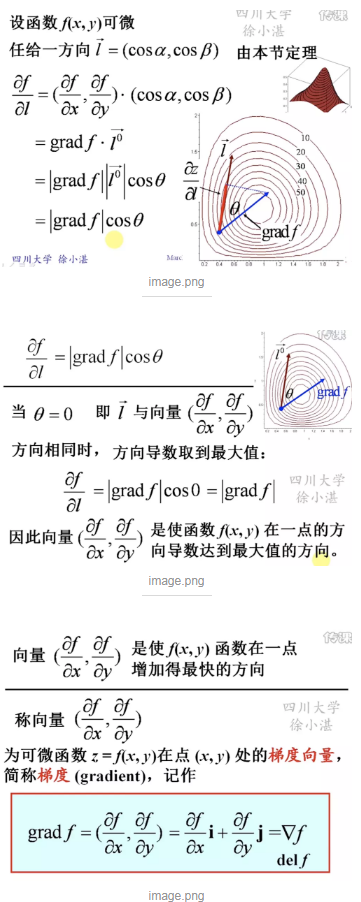

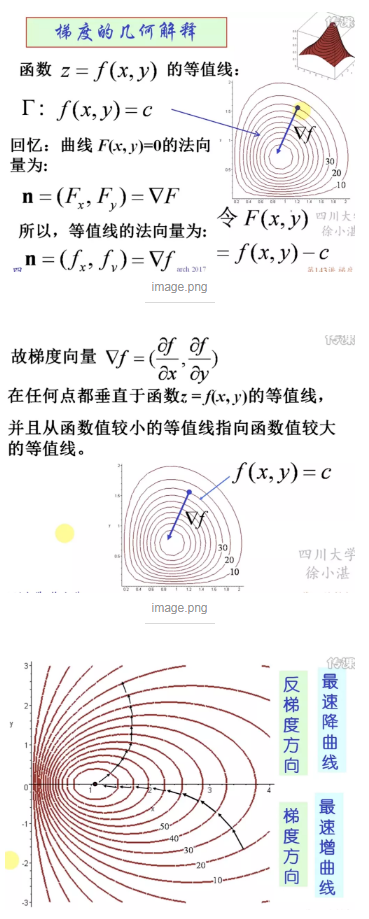

梯度

梯度的本意是一个向量(矢量),表示某一函数在该点处的方向导数沿着该方向取得最大值,即函数在该点处沿着该方向(此梯度的方向)变化最快,变化率最大(为该梯度的模)。

梯度下降算法

梯度下降是迭代法的一种,可以用于求解最小二乘问题(线性和非线性都可以)。在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降(Gradient Descent)是最常采用的方法之一,另一种常用的方法是最小二乘法。在求解损失函数的最小值时,可以通过梯度下降法来一步步的迭代求解,得到最小化的损失函数和模型参数值。反过来,如果我们需要求解损失函数的最大值,这时就需要用梯度上升法来迭代了。在机器学习中,基于基本的梯度下降法发展了两种梯度下降方法,分别为随机梯度下降法和批量梯度下降法。

梯度下降算法的缺点:靠近极小值时收敛速度减慢、直线搜索时可能会产生一些问题、可能会“之字形”地下降。