本文 是 NAACL 2018 最佳论文 Deep contextualized word representations 的前作,详细介绍了一种用预训练的双向语言模型提高其它模型(序列标注)效果的半监督方法。

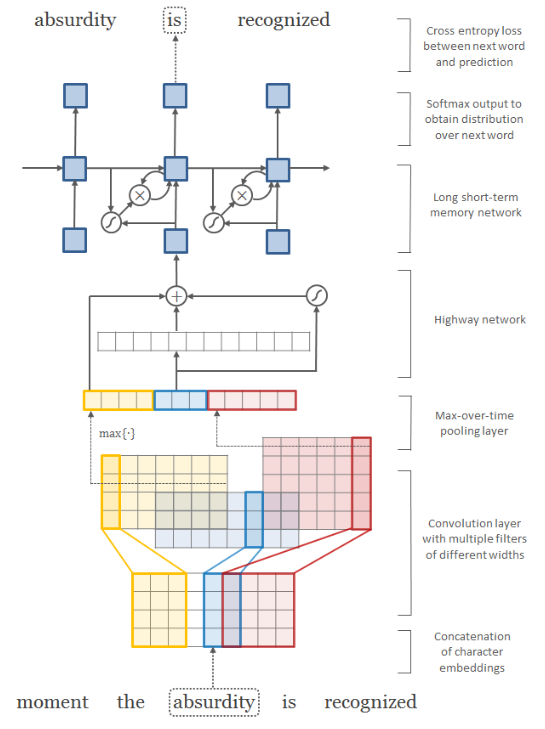

Character-Aware Neural Language Models

本文 是 NAACL 2018 最佳论文 Deep contextualized word representations 的 ELMo 模型字符卷积的基础。

注意点:

- 卷积核的高度一般与单词矩阵的高度一致(字符向量维度);

- 不同的卷积核宽度代表着不同的 N-gram 语法;

- 上图一共有 12 个卷积核,宽度一样的卷积核放在一起了(黄色、蓝色和红色);

ELMo Deep contextualized word representations翻译

ELMo Deep contextualized word representations

NAACL 2018最佳论文 Deep contextualized word representations:艾伦人工智能研究所提出新型深度语境化词表征(研究者使用从双向 LSTM 中得到的向量,该 LSTM 是使用成对语言模型(LM)目标在大型文本语料库上训练得到的。因此,该表征叫作 ELMo(Embeddings from Language Models)表征。)。

Keras手册

| 名称 | 网址 |

|---|---|

| Keras GitHub | https://github.com/keras-team/keras |

| Keras 英文官网 | https://keras.io/ |

| Keras 中文官网 | https://keras.io/zh/ |

| Keras 中文 | https://keras-cn.readthedocs.io/en/latest/ |

循环神经网络RNN长短期记忆网络LSTM与门控循环网络GRU

发表于

分类于

深度学习

RNN LSTM 最基本知识

RNNCell1

2

3

4

5

6

7

8

9

10

11import tensorflow as tf

import numpy as np

cell = tf.nn.rnn_cell.BasicRNNCell(num_units=128) # state_size = 128

print(cell.state_size) # 128

inputs = tf.placeholder(np.float32, shape=(32, 100)) # 32 是 batch_size

h0 = cell.zero_state(32, np.float32) # 通过zero_state得到一个全0的初始状态,形状为(batch_size, state_size)

output, h1 = cell(inputs, h0) #调用函数

print(h1.shape) # (32, 128)

SMP2018中文人机对话技术评测(ECDT)

点击查看GitHub SMP2018 完整代码和解析

| 标题 | 说明 | 时间 |

|---|---|---|

| CodaLab评测主页 | 数据下载 | 20181010 |

| CodaLab 评测教程 | 20181010 | |

| 评测排行榜 | ||

| SMP2018-ECDT评测主页 | ||

| SMP2018-ECDT评测成绩公告链接 |

Bag of Tricks for Efficient Text Classification

MarkDown问题

发表于

更新于

条件随机场 CRF

| 标题 | 说明 | 附加 |

|---|---|---|

| 如何轻松愉快地理解条件随机场(CRF)? | milter 浅析 | 2017 |

| 如何用简单易懂的例子解释条件随机场(CRF)模型?它和HMM有什么区别? | Scofield 详解 | 2018 |

| zh-NER-keras | 基于keras的BiLstm与CRF实现命名实体标注this project is a sample for Chinese Named Entity Recognition(NER) by Keras 2.1.4 | 2018 |

| 【中文分词】条件随机场CRF |